❖本調査レポートの見積依頼/サンプル/購入/質問フォーム❖

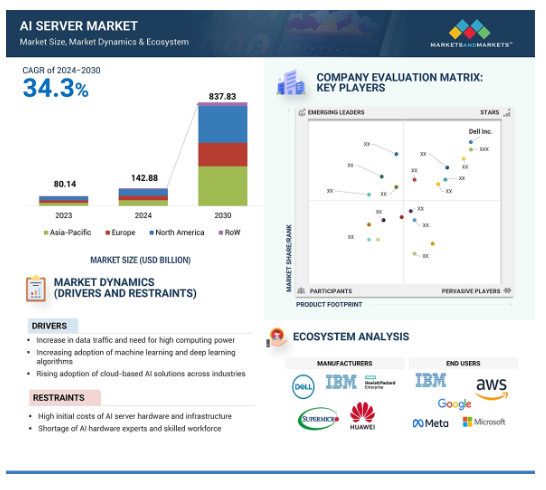

世界のAIサーバー市場は、2024年の1,428億8,000万米ドルから2030年には8,378億3,000万米ドルに成長し、予測期間中の年平均成長率は34.3%となる見込みです。市場を牽引するのは、ハイパースケール環境やジェネレーティブAI(GenAI)アプリケーションをサポートするために、クラウドサービスプロバイダーによるAIサーバーの採用が拡大していることです。GPTのような大規模言語モデル(LLM)に後押しされた推論機能に対する需要の増加は、NVIDIA(米国)やAMD(米国)などの大手企業によるデータセンターGPUの進歩を補完しています。GPUベースのサーバーセグメントは、2023年に最大の市場シェアを占めました。これは、膨大なAIワークロードを処理し、膨大なデータ量を処理する能力に起因しています。

AIサーバー市場における魅力的な機会

北米

北米は、2023年のAIサーバー市場で36.9%の最大シェアを占めています。

GPUベースのAIサーバーに対する需要の高まりは、AIサーバー市場のプレーヤーにとって有利な機会を生み出す可能性が高い。

米国政府による投資の増加、同地域における業界大手や新興AIサーバー企業の存在感の強さが、北米全域でのAIサーバー市場の成長を促進するでしょう。

Dell Inc.(米国)、Hewlett Packard Enterprise Development LP(米国)、Lenovo(香港)、Huawei Technologies Co. (中国)、IBM(米国)がAIサーバー市場の主要プレーヤーです。

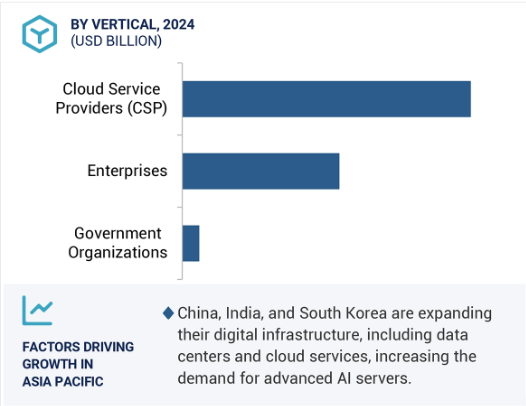

アジア太平洋地域は、さまざまなアプリケーションにおけるミキシング技術の急速な採用により、大きな市場シェアを占めると予想されます。

AIサーバーの世界市場ダイナミクス

DRIVER:データトラフィックの増加と高いコンピューティングパワーの必要性

コネクテッドデバイス、ストリーミングサービス、ソーシャルメディア、IoTによって急速に増加するデータトラフィックは、AIサーバーに対する高い需要を生み出しています。WiFi-7と5Gによるモバイル技術の進歩は、データ量の膨大な増加を引き起こします。組織は、この膨大なデータを効率的に処理、保存、分析するための強力なコンピューティング・ソリューションを必要としていました。GPUやASICのような特殊なチップを搭載したAIサーバーは、データ量の多いAIアプリケーションの計算需要を管理するように設計されています。エヌビディア・コーポレーション(米国)、アドバンスト・マイクロ・デバイセズ社(米国)、インテル社(米国)などのGPUは、グーグルのTPUのようなASICとともに、ニューラルネットワークのトレーニングや推論などのタスクを高速化します。グーグルは2024年5月、AIワークロードによる大規模計算を処理するための第6世代Tensor Processing Unit(TPU)「Trillium」を発表。このTPUは、高帯域幅メモリ(HBM)とチップ間相互接続(ICI)の帯域幅を倍増させるとともに、超大規模エンベッディング用のアクセラレータを搭載しています。これらの機能強化により、AIモデルの迅速なトレーニングと展開が可能になり、リアルタイムの意思決定と分析をサポートします。これらの開発により、AIアプリケーションは大量のデータを迅速に処理できるようになります。このため、AIサーバーは最新のデータ・トラフィックを管理する上でますます重要になり、市場の成長を促進しています。

抑制要因:AIサーバーのハードウェアとインフラの初期コストの高さ

高性能ハードウェアには多額の投資が必要となるため、AIサーバーとインフラの初期コストが高いことがAIサーバー市場の主要な阻害要因となっています。複雑なアルゴリズムを実行し、大規模なデータセットを効率的に処理するために使用されるGPUやASICSのような特殊なコンポーネントのために、高度なAIサーバーのセットアップコストが高いです。一般的に、これらのコンポーネントの調達コストは標準的なサーバー・ハードウェアよりもはるかに高く、それによってコストが増加します。そのため、組織はAIソリューションを採用するために割高な費用を支払う必要があり、当然ながら先行投資と潜在的なリターンを天秤にかけることになります。これは多くの組織、特に予算やリソースが潤沢でない組織にとって障壁となります。さらに、財務面はハードウェアの購入だけにとどまりません。AIサーバーの最適なパフォーマンスを実現するには、電源、冷却、ネットワーク機器などのインフラ設定コストも必要です。これらのコストは、全体的なコストに余裕のない小規模な組織や新興企業にとっては障害となります。経済的なプレッシャーが最先端技術へのアクセスを制限し、その結果、このようなコストを吸収する能力という点で、大企業と中小企業との間に格差が生じています。

可能性:クラウドサービスプロバイダーによるデータセンターへの投資の増加

クラウドサービスプロバイダー(CSP)によるデータセンターへの投資の増加は、AIサーバー市場のプレーヤーに大きな成長機会をもたらします。このようなデータセンターの拡大は、AIワークロードのサポートに必要な高性能コンピューティングインフラの需要を促進します。マイクロソフトやAWSなどのCSPは、AIベースのアプリケーションの需要増に対応するため、データセンター・インフラのアップグレードに継続的に投資しています。例えば、2024年3月、AWSは53億米ドルを投資してデータセンターを建設し、サウジアラビアで主要なクラウドプレゼンスを構築しました。2023年11月、マイクロソフト(米)はケベック州に複数のデータセンターを新設し、カナダでのプレゼンスを拡大すると発表。同社は、今後2年間でケベック州におけるクラウド・コンピューティングとAIインフラの拡大に5億米ドルを投資する計画を発表。これらの施設は、GPU、TPU、AIアクセラレーターなどの高度にカスタマイズされたハードウェアを搭載した高度なAIサーバーによって、大規模な機械学習やリアルタイムの推論など、AIモデルの集中的な計算要件を処理するように設計されています。こうした動きは、AIサーバー市場に成長機会をもたらしています。

課題:サプライチェーンの混乱

サプライチェーンの混乱は、AIサーバー市場のプレーヤーにとって大きな課題であり、生産能力、納期、全体的なコストに影響を与えています。高性能GPUやその他の半導体材料は重要な部品であり、その不足によりサーバーの生産に遅れが生じています。これは、製造能力の限界、高度なサーバー技術の処理における非効率性、設備の故障が原因です。AIサーバーの需要が高まるにつれ、特にデータセンターやAI主導のアプリケーションで使用されるため、主要部品のリードタイムが延び、サーバーの可用性がさらに遅れる可能性があります。ハードウェアメーカーは生産期限を守るのに苦労しており、それがAIサーバーの納期の遅れにつながっています。これは、AIインフラストラクチャを構成するためにこれらのサーバーに依存しているシステムインテグレーターにも影響し、その結果、顧客へのAIソリューションの展開も遅れます。AIサーバーを必要とするクラウドサービスプロバイダーも、この問題に直面しています。例えば、NVIDIA H100およびA100 GPUの需要は非常に高く、GPUサーバーのリードタイムは最大52週間まで延びています。この長いリードタイムは、AIインフラストラクチャに高性能GPUを必要とする組織にとって問題となります。

AIサーバー市場のエコシステム

AIサーバーのエコシステムは、AIチップとメモリのサプライヤー、PSU、PMIC、冷却システム、シャーシのサプライヤー、メーカー、エンドユーザーで構成されています。これらの関係者は、知識、リソース、専門知識を共有することで、AIサーバーの発展を目指します。AIサーバーメーカーとしては、Dell Inc.(米国)、Hewlett Packard Enterprise Development LP(米国)、Huawei Technologies Co. (中国)、IBM(米国)などがAIサーバー市場の中核を担っています。

予測期間中、GPUベースのサーバーセグメントが最大の市場シェアを占める見込み

GPUベースのサーバーセグメントは、AIサーバー市場で最大のシェアを占めると推定されています。GPUベースのサーバーは、グラフィックス・プロセッシング・ユニットの並列処理能力を活用して人工知能ワークロードを高速化するために高度にカスタマイズされたシステムです。これらのサーバーは、複数の処理を同時に処理できるため、ディープラーニング、ニューラルネットワークのトレーニング、大規模なデータ分析処理に最も効果的です。GPUベースのAIサーバーの開発では、NVIDIA Corporation(米国)、Hewlett Packard Enterprise Development LP(米国)、IBM(米国)、Advanced Micro Devices, Inc(米国)が優勢。2023年11月、NVIDIAはNVIDIA HGX H200を発表し、世界をリードするAIコンピューティングプラットフォームを強化しました。NVIDIA Hopperアーキテクチャをベースに構築されたこのプラットフォームには、ジェネレーティブAIやハイパフォーマンス・コンピューティング向けに大量のデータを効率的に管理する高度なメモリ機能を備えたNVIDIA H200 Tensor Core GPUが搭載されています。2023年1月、シスコシステムズ社は、インテル コーポレーションとの協業により、第4世代インテルXeonスケーラブル・プロセッサーを搭載した第7世代UCS CシリーズおよびXシリーズ・サーバーを発表しました。この新プラットフォームは、次世代ワークロードのための柔軟性とパフォーマンスを向上させ、UCS Xシリーズ・ファブリック・テクノロジーでインテルのData Center GPU Flexシリーズをサポートします。

予測期間中、クラウドサービスプロバイダー(CSP)セグメントが最大の市場シェアを占める見込み

AIサーバー市場をリードするのはクラウドサービスプロバイダー(CSP)。AIサーバーにより、これらのプロバイダーは、IoTデバイス、ソーシャルメディア・プラットフォーム、企業アプリケーションから生成される膨大なデータセットをかつてないスピードで処理・分析することができます。企業は、データ分析、機械学習、自然言語処理、その他の高度なコンピューティング・タスクのために、ますますAIに頼るようになっています。Amazon Web Services, Inc.(AWS)、Microsoft Azure、Google CloudなどのCSPは、スケーラブルでコスト効率の高いAIソリューションを世界中の企業に提供することで、この変革をリードしています。GPUサーバーは、リアルタイムのAI処理に必要な膨大な計算負荷を処理するため、重要な役割を果たします。企業が業務改善のためにAIを採用し続けるにつれ、CSPデータセンターにおけるAIサーバーの需要は高まるでしょう。CSPは、データセンターの強化とAIサービスの提供のために、AIサーバーに多額の投資を行っています。NVIDIAは2024年3月にDGX Cloudを発表しました。これはAIスーパーコンピューティングサービスであり、企業はシンプルなウェブインタフェースを通じてNVIDIA DGX AIスーパーコンピューティングの専用クラスタにアクセスすることができます。このサービスは、オンプレミスのインフラストラクチャの調達と管理を簡素化し、AIワークロードを時間遅延なく拡張します。

予測期間中、推論機能が最大の市場シェアを占める見込み

予測期間中、最大の市場シェアを占めると推定されるのは推論セグメントです。推論とは、新しい未知のデータに対して学習済みのAIモデルを採用し、予測を生成したり、意思決定を行ったり、同じデータから洞察を得たりするプロセスを指します。学習中にデータセットからパターンや関係を学習した事前学習済みモデルを使用することで、新たな入力の分析が可能になり、この学習済みの知識に基づいて出力が得られます。リアルタイムの高性能アプリケーションには非常に特殊な計算が必要であり、AIサーバーによって最適かつ高速な推論が行われます。テンソル・プロセッシング・ユニット(TPU)やグラフィックス・プロセッシング・ユニット(GPU)は、多数の推論処理を同時に実行する並列処理用に設計されています。この機能は大量のデータを迅速に処理するために必要であり、これらのサーバーは高スループットの推論タスクに最適です。エッジコンピューティングへのシフトは、一般的に、集中型のクラウドサーバーではなく、よりソースに近い場所でデータを処理する傾向を指しており、AI推論サーバーのもう一つの原動力となっています。サーバーはエッジ環境に最適化されるように設計されており、IoT対応スマートデバイスの重要な側面である低レイテンシーで迅速なデータ処理を実現します。

アジア太平洋地域が予測期間中にAIサーバー市場で最も高いCAGRを記録

アジア太平洋地域のAIサーバー市場は、予測期間中に最も高い成長を記録すると予測されています。アジア太平洋地域は、AIの研究、開発、展開において著しい進歩を目の当たりにしてきました。中国、日本、韓国、シンガポールのような国々は、AI研究とインフラストラクチャに多額の投資を行い、学界、産業界、政府間の強力な協力関係を促進しています。この相乗効果により、機械学習、自然言語処理、コンピュータ・ビジョンにおいて大きな飛躍がもたらされました。アジア太平洋地域の各国政府はAI技術に積極的に投資しており、AIアプリケーション専用に設計されたデータセンターなど、AIインフラの整備に多額の資金を投入しています。例えば、中国の「次世代人工知能開発計画」は、2030年までに同国をAIの世界的リーダーとして位置づけ、AIサーバーの開発と展開のための強固なエコシステムを育成することを目指しています。韓国と日本でも同様の取り組みが行われており、AI機能が強化されつつあります。同地域の企業がAI技術を取り入れるにつれて、複雑なAIワークロードをサポートできる高性能サーバーの需要が急増し、アジア太平洋地域のAIサーバー市場に新たな成長機会が生まれると予想されます。

AIサーバー市場の最新動向

2024年9月、デル株式会社とレッドハットは、Dell PowerEdgeサーバー上のAIワークロードに適したプラットフォームとしてRed Hat Enterprise Linux AI(RHEL AI)を採用するために協業しました。このパートナーシップは、NVIDIA GPUを含むハードウェアの継続的なテストと検証によってAIの導入を簡素化し、AIモデルのシームレスな開発と導入を実現することで、企業がビジネス・アプリケーション全体でAI/ML戦略を加速できるよう支援します。

2024年9月、Hewlett Packard Enterprise Development LPは、Gen11エッジサーバーポートフォリオの一部であるHPE ProLiant DL145 Gen11サーバーを発表しました。このサーバーは、多様なエッジワークロード向けに高いパフォーマンスを提供します。在庫管理、POS、AI/MLワークロードなどのアプリケーションをサポートします。このサーバーは、エッジに特化したソリューション向けに最適化されており、ISVパートナーのエコシステムが拡大し、小売業や製造業など向けにカスタマイズされたソリューションを提供しています。

2024年9月、レノボはインドでのAIサーバー製造開始を発表し、インドでのプレゼンスを拡大しました。レノボはベンガルールにインフラストラクチャー研究開発ラボを開設し、インドへのコミットメントにおける重要なマイルストーンとなりました。この施設では、年間50,000台のAIサーバーと2,400台のハイエンドGPUユニットを生産する予定です。このR&Dラボは、インドの「Made in India」と「AI for All」のビジョンに沿い、サーバー技術のグローバルなイノベーションを推進します。

2024年5月、シスコシステムズ社とレノボは、ネットワーキングとジェネレーティブAIソリューションに特化した統合製品を共同で開発するパートナーシップを締結しました。この合意には、シスコのネクサス・ネットワーキング・エコシステムをレノボのエッジ・トゥ・クラウド・ポートフォリオに組み込むことも含まれており、相互運用性の向上を目指しています。レノボのカーク・スカウゲンによると、この取り組みは、顧客のAIイノベーションとデジタルトランスフォーメーションの簡素化を目指すもの。

IBMは2024年5月、Power S1012を発表しました。Power S1012は、Power S812よりもコアあたりのパフォーマンスが最大3倍向上した、エッジ・コンピューティング向けに最適化された1ソケット、ハーフ幅のPower10サーバーです。2Uラック型またはタワー型で提供され、遠隔地でのAI参照やクラウド統合に柔軟に対応します。中小企業向けに手頃なエントリーポイントを提供します。

主な市場プレイヤー

AIサーバー市場トップリスト

Dell Inc. (US)

Hewlett Packard Enterprise Development LP (US)

Lenovo (Hong Kong)

Huawei Technologies Co., Ltd. (China)

IBM (US)

H3C Technologies Co., Ltd. (China)

Cisco Systems, Inc. (US)

Super Micro Computer, Inc. (US)

Fujitsu (Japan)

INSPUR Co., Ltd. (China)

NVIDIA Corporation (US)

ADLINK Technology Inc. (Taiwan)

Advanced Micro Devices, Inc. (US)

Quanta Computer lnc. (Taiwan)

WISTRON CORPORATION (Taiwan)

15.1 主要プレーヤー